CET ARTICLE A INITIALEMENT ÉTÉ PUBLIÉ DANS ARCHIMAG N°383 : Transformation digitale : les méthodes et outils pour réussir sa gestion de projet

CET ARTICLE A INITIALEMENT ÉTÉ PUBLIÉ DANS ARCHIMAG N°383 : Transformation digitale : les méthodes et outils pour réussir sa gestion de projet

Découvrez L'Archiviste Augmenté, la newsletter thématique gratuite d'Archimag dédiée aux professionnels des archives et du patrimoine !

Découvrez L'Archiviste Augmenté, la newsletter thématique gratuite d'Archimag dédiée aux professionnels des archives et du patrimoine !

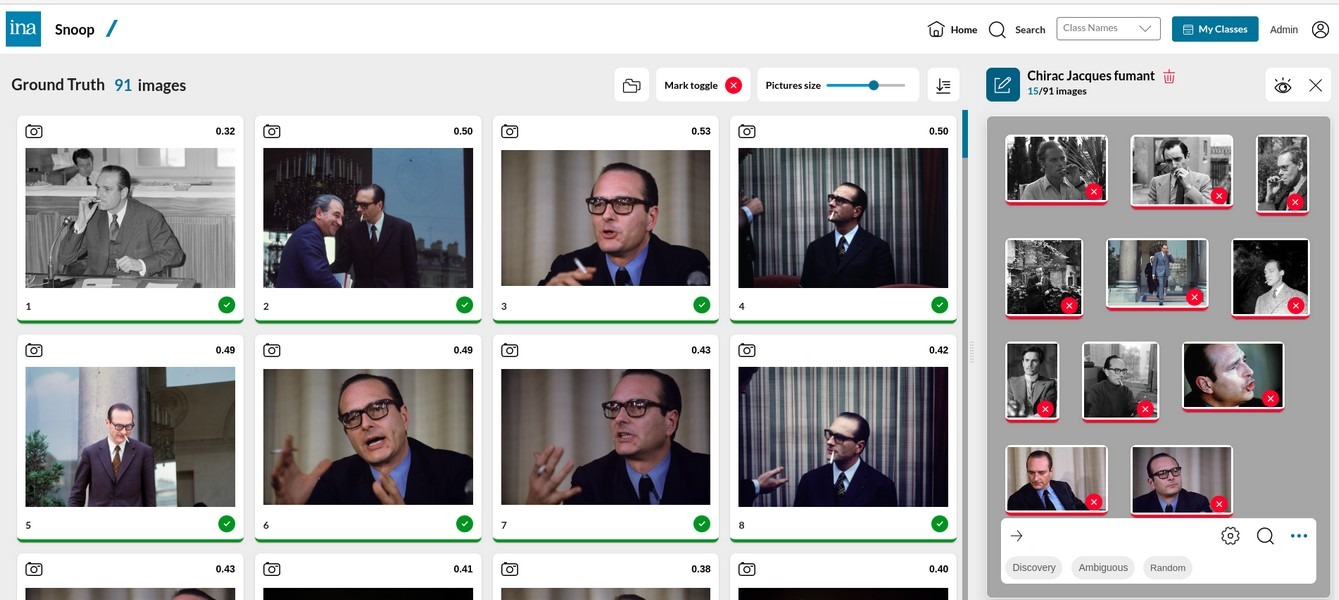

Retrouver toutes les apparitions de Jacques Chirac avec une cigarette à la bouche après avoir fouillé les archives audiovisuelles de l’Institut national de l’audiovisuel (Ina)… C’est l’une des prouesses rendue possible grâce à Snoop, un moteur de recherche visuel d’apprentissage et de prédiction à très large échelle qui repose sur une technologie d’intelligence artificielle (IA) visuelle.

Un projet collaboratif de longue date

Le projet Snoop, qui tire son nom du verbe anglais "fouiner", a débuté il y a vingt ans pour répondre à une problématique spécifique : "nous voulions identifier avec précision la diffusion de nos archives pour automatiser la gestion des droits d’auteurs", explique Olivier Buisson, responsable R&D de l’Ina. "Nous avons ensuite saisi le potentiel de cette technologie pour la réutiliser à des fins de reconnaissance visuelle d’objets ou de personnes, par exemple".

Capable d’explorer - pour le moment - 780 000 photos et vidéos numérisées de l’Ina, Snoop a été amorcé grâce aux travaux du Dr Alexis Joly, ancien doctorant au service de la recherche de l’Ina, et du Dr Olivier Buisson, puis pérennisé avec la collaboration du Dr Jean-Christophe Lombardo. L’outil a connu de nombreuses optimisations et évolutions au gré de collaborations scientifiques et techniques entre les chercheurs du service de la recherche et les doctorants de l’Ina, qui continue d’encadrer et de cofinancer des recherches et des thèses sur ce sujet en collaboration avec l’Institut national de recherche en sciences et technologies du numérique (Inria).

Lire aussi : Ina : l’IA au service de la découverte du patrimoine audiovisuel français

Déjà disponible pour le grand public suite à son intégration au sein de l’application Pl@ntNet, développée par l’Inria, Snoop permet d’identifier pas moins de 200 000 types de plantes. À l’Ina, mais aussi à la Bibliothèque nationale de France (BnF) au sein de la base de données Gallica (25 millions de photos), les chercheurs s’approprient l’outil depuis déjà cinq ans. "La BnF ne participe pas au développement du moteur, mais exprime des besoins et des adaptations sont intégrées par la suite selon les choix de l’Ina et l’Inria", précise Nicolas Hervé, responsable du service de la recherche à l’Ina. "Les chercheurs du Datalab sont utilisateurs et pourvoyeurs de cas d’usage pour l’aide à la recherche documentaire".

Proche du fonctionnement du cerveau humain

Sans recourir aux métadonnées textuelles, le modèle d’IA de Snoop se rapproche du fonctionnement d’un cerveau humain : tout commence par un processus préparatoire "offline" (hors ligne) sur un ou plusieurs serveurs à partir d’un corpus de très grande taille. L’IA Snoop décrit ensuite ces images en s’appuyant sur des réseaux de neurones entraînés à établir des liens entre les éléments visuels présents et leur équivalent sémantique dans le langage humain.

Sans recourir aux métadonnées textuelles, le modèle d’IA de Snoop se rapproche du fonctionnement d’un cerveau humain : tout commence par un processus préparatoire "offline" (hors ligne) sur un ou plusieurs serveurs à partir d’un corpus de très grande taille. L’IA Snoop décrit ensuite ces images en s’appuyant sur des réseaux de neurones entraînés à établir des liens entre les éléments visuels présents et leur équivalent sémantique dans le langage humain.

Ces liens se traduisent sous la forme de descripteurs visuels, convertis en nombre, puis modélisés en vecteurs mathématiques. Stockés dans une base de données et indexés dans le moteur de recherche, ces vecteurs permettent d’identifier les similarités entre les images. Plus les vecteurs se ressemblent, plus leurs images respectives ont de chances de représenter un même concept et d’être liées sémantiquement. À l’instar d’une base de données ou d’un moteur de recherche classique, les nouvelles images et vidéos sont incrémentées au fur et à mesure avant d’être traitées par l’IA et recalculées dans l’index. Par ailleurs, Snoop a été créé avec des coûts énergétiques de calculs et de stockage réduits (peu onéreux en CPU et mémoire) afin d’être économiquement viable.

Lire aussi : L'Ina valorise 27 millions d'heures d'archives audiovisuelles sur Data.ina grâce à l'IA

Interaction avec les utilisateurs

Snoop se distingue par son apprentissage inteactif avec un humain dans la boucle. Grâce à un système de classement en "paniers", l’utilisateur affine ses recherches et optimise ainsi la précision des futurs résultats. Baptisé "RFLooper" (Relevant Feedback), ce mécanisme de recherche visuelle interactive permet de personnaliser des recherches qui ne peuvent pas simplement être exprimées avec du texte. Selon le principe de "vérités terrain" et de transparence vis-à-vis des usagers, des pastilles vertes (+50 %) ou rouges (-50 %) prédisent la pertinence des images.

"Pour les IA visuelles, ces contre-exemples sont essentiels pour améliorer les capacités, la précision et les résultats de leurs modèles mathématiques", indique Olivier Buisson. Le rôle des utilisateurs occupe donc une place centrale dans l’amélioration de l’IA de Snoop afin que l’outil assimile de nouveaux concepts.

Pour Nicolas Hervé, "l’intérêt est de capitaliser sur les résultats de recherche des utilisateurs obtenus par une sélection positive, puisque de nombreux sujets de recherches sont difficilement exprimables autrement, faute de métadonnées suffisantes ou en raison de limitations d’indexation". À terme, Snoop pourra retrouver des concepts avec moins d’intervention et croiser des éléments avec précision grâce à la reprise d’antériorité.

Outiller les chercheurs et les journalistes

Plusieurs chercheurs ont déjà pu mettre à l’épreuve les capacités de Snoop. Certains, en sciences humaines et sociales, l’ont testé pour automatiser des analyses visuelles qui seraient autrement fastidieuses. Par exemple, l’outil a permis d’identifier tous les extraits de programmes où figurent des smartphones ou des tablettes, par exemple.

Lire aussi : La BnF et l'Ina en négociation avec le consortium ARGIMI pour alimenter la future IA générative

Snoop a aussi été testé pour apporter de l’aide dans le cadre des usages commerciaux de l’Ina Mediapro, le service de vente d’archives audiovisuelles de l’Ina à destination des professionnels (800 000 heures). Par exemple, lors de l’incendie de Notre-Dame de Paris, en avril 2019, les documentalistes ont pu retrouver une centaine d’extraits où figurait l’édifice gothique au sein de la base de données d’Ina Mediapro pour répondre aux demandes des journalistes d’archives télévisées de la cathédrale.

De son côté, Olivier Buisson a fait passer les tests à Snoop sur un corpus plus réduit de 60 000 heures d’Ina.fr (déjà traité en processus "offline"), duquel il a pu extraire 200 extraits de Notre-Dame, dont une centaine en commun avec les résultats de la méthode classique. "Cet écart s’explique par les annotations associées aux vidéos à l’échelle du plan ou de la vidéo dans les bases de données d’Ina Mediapro", explique-t-il. "Snoop dépasse cette limite en retrouvant des extraits calés à l’image".

À moyen terme, les capacités de Snoop devraient encore se perfectionner grâce à l’interaction avec les utilisateurs. Sur le plan scientifique, l’Ina et l’Inria ambitionnent un développement continu avec l’appui de doctorants.